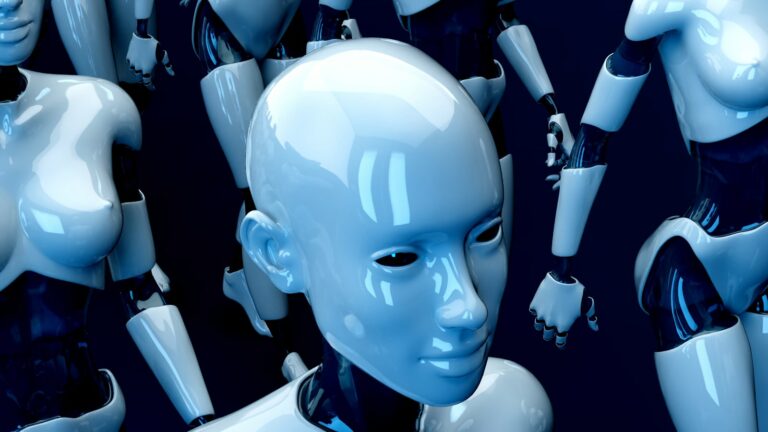

Agentes de IA

La inteligencia artificial (IA) está revolucionando la forma en que interactuamos con el mundo. Entre las aplicaciones más interesantes y útiles se encuentran los agentes de IA, programas diseñados para realizar tareas específicas, aprender de la experiencia y adaptarse a nuevas situaciones. En este artículo, exploraremos qué son los agentes de IA, cómo funcionan y…